gensynとは?エアドロップの狙い方やプロジェクト内容を徹底解説

仮想通貨(暗号資産)の領域として「AIとの融合」をアピールするプロジェクトが急増しています。

こちらの記事で紹介するgensynもその1つ。分散型コンピューティングを活用し、AIモデルのトレーニングに必要な大規模計算リソースを低コストで共有しようとする新興プロジェクトです。

gensynとはどんなプロジェクトなのか、エアドロップの狙い方などについて解説します。

gensynとは?

gensynは「分散型のAI計算ネットワーク」を構築することを目指すプロジェクトです。

クラウド大手(AWSやAzureなど)が提供しているGPUリソースを、より安価かつ民主化された形で誰でも利用できるようにしようという試みです。

GPUは「Graphics Processing Unit」の略で、本来はゲームなどの画像処理に使われる特殊なチップです。膨大な並列計算が得意なため、現在のAI計算に不可欠な部品となっています。

個人が所有するゲーミングPCから大規模データセンターに至るまで、多様なハードウェアを「ノード」としてネットワークに接続し、計算能力を必要とするユーザーとのマッチングを実現します。

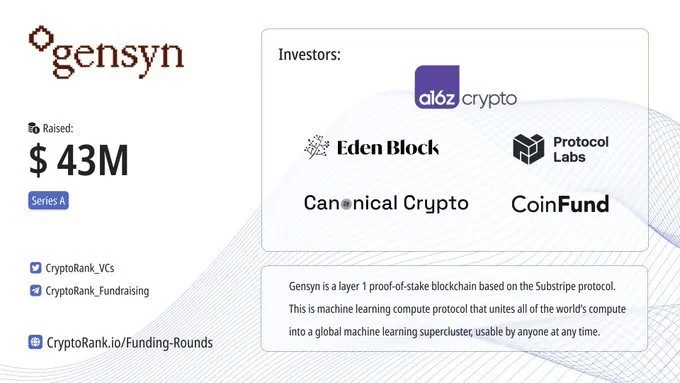

a16zなどから計5060万ドルを調達

2022年から2023年にかけて行ったシードラウンドとシリーズAで合計5,000万ドルを超える巨額の資金調達に成功し、a16zやProtocol Labsといった著名投資家が名を連ねています。

特にProtocol Labsは分散ストレージで知られるFilecoinやIPFSを育ててきた組織であり、Gensynとの協業を通じて「分散ストレージ+分散計算」というより強力なエコシステムの形成を狙っていると考えられます。

gensynの特徴と競合優位性

信頼できるAIのトレーニング環境を提供

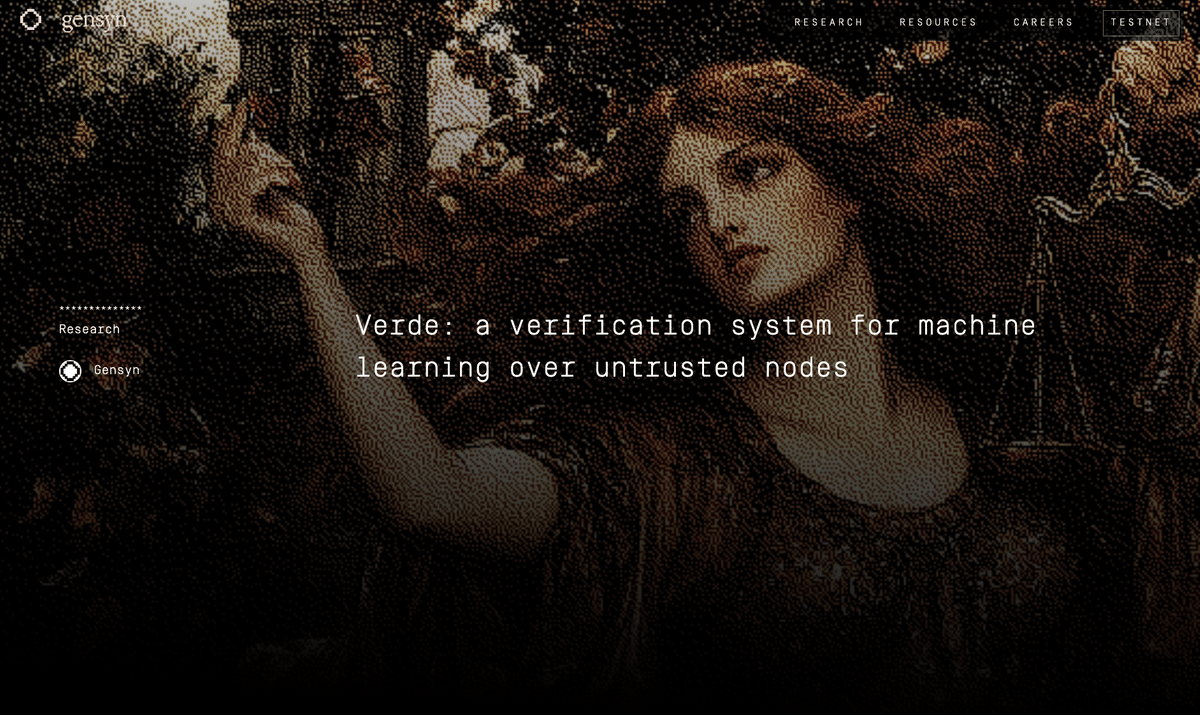

gensynが掲げる革新的な点は、ブロックチェーン上で「本当に学習タスクが正しく実行されたのか」をチェックできる検証の仕組み(Proof of Learning など)を採用している点です。これにより、不正計算を防ぎつつ、計算結果への信頼を担保しようとしています。

クラウドの代替手段を目指すうえでも、単なる「計算時間の安売り」ではなく「信頼できる結果を得る」ことまで保証する点が大きな強みとなっています。

検証方法(Verde)の詳細:https://www.gensyn.ai/articles/verde

大規模ネットワークによるコスト優位性

大量のGPUを保有するクラウド事業者を使う場合、トレーニングが大規模になるほど利用料が高騰し、「AIモデル開発は一部の大手企業のもの」という構図になりがちです。

Gensynはこうした課題に対し、世界規模で余剰GPUを集めるネットワークをつくり、安価に提供することを目指しています。

個人用のPCを含む世界中の遊休GPUなどを再活用できれば、コスト面で大幅な削減が期待できます。これが実現すれば、多くのスタートアップや研究機関がより自由に大規模AIプロジェクトに挑戦できるようになるでしょう。

回復力とアクセスの広さ

集中管理されない分散ネットワークは、個々のノード(コンピューター)が落ちても全体がダウンしにくいという回復力を持ち合わせています。

さらに、電力コストの安い地域のリソースを活用するなど、世界規模でリソースを最適に配分できる可能性があります。

こうした分散化のメリットは、既存の大手クラウドが独占している領域を切り崩すだけでなく、地域や資金力に左右されない「AI開発の民主化」に直結すると考えられます。

トークン設計とエコシステム戦略

gensynのトークンは、ネットワークを利用するAI開発者が計算に貢献するノード「Solver」たちに支払う報酬となる予定です。

計算リソースを提供するノードが報酬を受け取り、さらに結果を検証するノードにもインセンティブが配分される構造です。

また、コミュニティガバナンスの仕組みを導入し、プロトコルのアップデート内容や報酬分配率などをトークン保有者が投票で決定できるようにする計画も示唆されています。

競合優位性

分散型GPUコンピューティング市場では、いくつかの注目すべきプロジェクトが異なるアプローチで発展を続けています。

gensyn: AIモデルのトレーニングに特化。「このAIの学習は本当に正しく行われたのか?」を証明する暗号学的検証メカニズムで信頼性を担保。a16zなど著名投資家の支援を受け、5000万ドル以上を調達。テストネット段階で、まだトークン未上場。

io.net: 高性能GPUリソースを低コストで提供し、すでに作られたAIを動かすことに強み。「Proof of AI」という検証システムも持っていますが、GensynのようなAIトレーニング自体の検証というよりは、ハードウェアの性能確認に重点を置いています。

既存クラウドと比較して最大90%のコスト削減を実現。5万以上のGPUを接続する大規模ネットワークを構築済み。2024年に3000万ドルを調達。FDVは約6億ドルに達し、市場から高い評価。

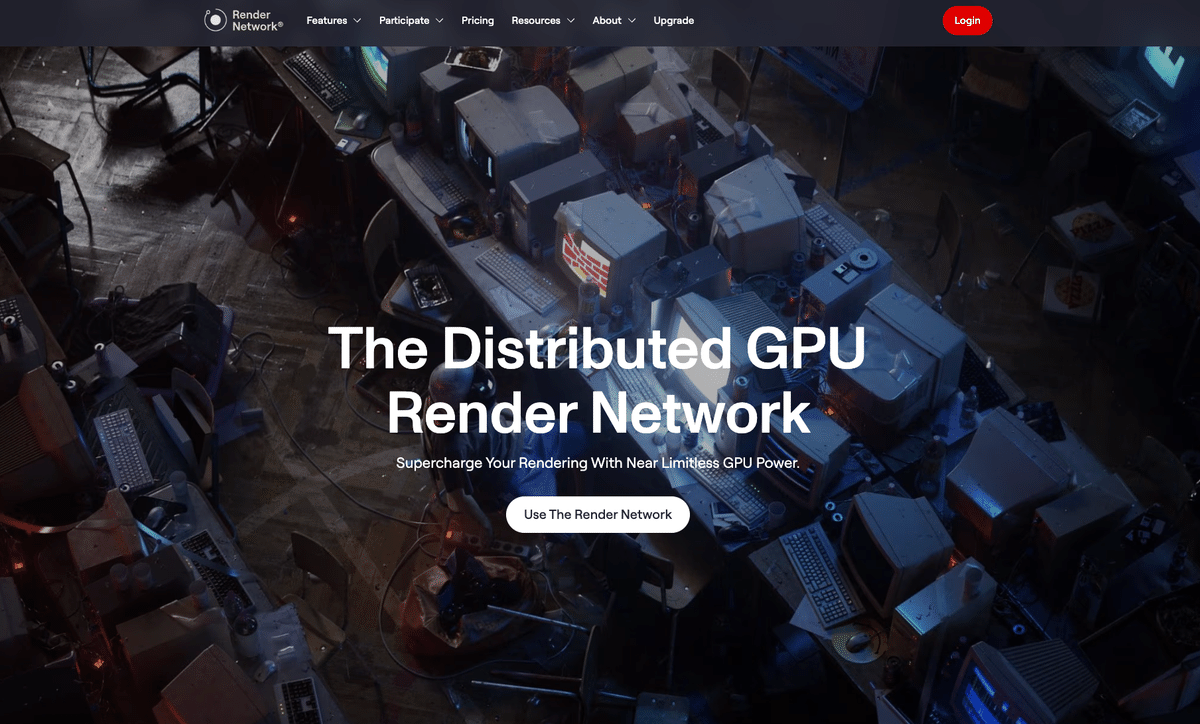

Render Network: Render Networkは元々、3Dアニメーションや映像の「レンダリング」(3Dデータから映像を作り出す処理)のための分散コンピューティングプラットフォームでした。

最近ではAI処理にも対応を広げています。クリエイティブ産業との強いつながりを活かした独自エコシステムが特徴。最も成熟したコミュニティと開発者基盤を持つ。2021年に6000万ドルを調達。FDVは約18億ドルで、実績に裏打ちされた評価。

これら3プロジェクトはいずれも「AIの民主化」という共通ビジョンを持ちながらも、異なる領域とアプローチで市場を開拓しています。

gensynは最も特化型で、学習過程の検証という革新的な価値提案を持つプロジェクトとして注目されています。

エアドロップについて

エアドロップの可能性は高い

上記の通り、gensynはトークンを必要とする設計のため、トークンを発行することは間違いありません。

エアドロップの実施に関しては不確定ですが、分散型のAI計算ネットワークを目指すgensynはトークンをコミュニティに配布する可能性は高いと考えています。

さらにはライトペーパーにはテストネット参加者へ報酬を配るような記載があるため期待していいと思います(約2年前に調べてたのにnote執筆時まで忘れてました💦)

エアドロップの狙い方

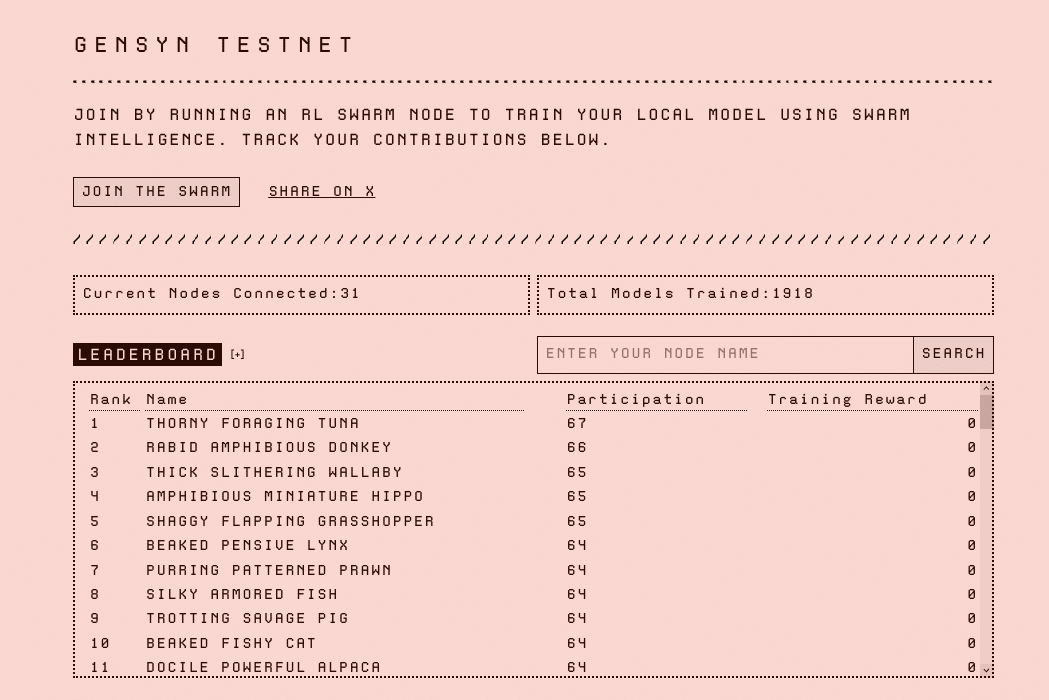

gensynは2025年4月1日にテストネットを公開。おそらくいくつかのテストネットのフェーズに応じたタスクをおこなうことで、メインネットの始動時にエアドロップの対象となることが期待されます。

フェーズ0(2025年4月〜)の参加手順

概要

テストネットの第一フェーズでは、「RL Swarm」と呼ばれるインターネット上での協調型強化学習システムへの参加追跡に焦点を当てています。

オンチェーンIDを取得し、ノードを稼働させることで「トレーニング報酬」が獲得可能です。ただしこれがそのままトークンの報酬を示しているのかは不明です。

また、ローカル環境のみであれば無料ですが、一定のPCスペック×稼働時間が必要とされるため、アカウントを増やすごとにコストがかかります。加えて要求されるスペックが高めなので大量のアカウントで稼働させるのはあまり現実的ではないかもしれません(検証中)。

必要な環境

〈ハードウェア要件〉

- CPU: arm64 または x86 CPU (最低16GB RAM)

- または以下のGPU:

- RTX 3090

- RTX 4090

- A100

- H100

〈ソフトウェア要件〉

- Python 3.10以上

- Git

- npm (最新版推奨)

セットアップ手順

基本的には公式のGithub(https://github.com/gensyn-ai/rl-swarm)を参照して進めましょう。

ワンクリックでノードを建てられるサービスもありますが、割高なので今後のためにもChatGPTやClaudeなどに聞いて自分で動かすことをおすすめします。エラーが出るような場合でも、聞いたらほとんど答えてくれるはずです。

※私もAIに聞きながら書いているので、間違った部分があったらすみません。

1. リポジトリのクローンとセットアップ

# リポジトリをクローン

git clone https://github.com/gensyn-ai/rl-swarm

cd rl-swarm

# Python仮想環境の作成と有効化

python3 -m venv .venv

source .venv/bin/activate2. RL Swarmの起動

./run_rl_swarm.sh3. テストネットへの接続

- スクリプト実行時に「テストネットに参加しますか?」という質問が表示されます

- 「Y」を入力するか、そのままEnterを押してください

4. ログイン手順

- ブラウザが自動的に開きます

- VMを使用している場合は手動で http://localhost:3000/ にアクセスしてください

- 「login」ボタンをクリックします

- お好みの認証方法でログインしてください

5. Hugging Face連携 (オプション)

- Hugging Faceアカウントとの連携を行う場合は、トークンを使用して設定できます

- 意味があるかわかりませんが、連携しているユーザーは全体の1/10ほどなのでやっておいてもいいかも

自分のアカウントの確認方法

ログの下記のxxxの部分に3つの単語とPeerID(長い不規則な英数字)が表示されます。

INFO:hivemind_exp.runner.grpo_runner:🐱 Hello 🐈 [xxx xxx xxx] 🦮 [xxxxxxxxxxxxxxxxxxxxxxxxx]!稼働期間が上位100名になると、ダッシュボードで順位の確認が可能です(今後、PCスペックも考慮されるトレーニング報酬での順位になりそう)

Gensyn | TestnetThe Gensyn Public Testnet brings persistent identity to decendashboard.gensyn.ai

※セキュリティに関する注意

- `swarm.pem` ファイルは重要な認証情報を含むため、安全に管理してください

- 別のマシンに移行する場合は、この `swarm.pem` ファイルをバックアップして新しいマシンに移行することで、同じピアIDを維持できます

よくある問題と解決方法

- モデルのトレーニングが進んでいないように見える場合

- 一般的なデバイス(MacBookなど)を使用している場合は、処理が遅い可能性があります

- 20分程度待ってから再度確認してください

- MacBookでメモリ不足エラーが発生する場合

export PYTORCH_MPS_HIGH_WATERMARK_RATIO=0.0- Protobufのエラー

`rl-swarm`をセットアップしたり、実行しようとしたりすると、時々「Protobuf」というツールのバージョンが合わないことでエラーが出ることがあります。エラーメッセージはこんな感じです:

google.protobuf.runtime_version.VersionError: Detected incompatible Protobuf Gencode/Runtime versions when loading runtime.proto: gencode X.Y.Z runtime A.B.C. Runtime version cannot be older than the linked gencode version. See Protobuf version guarantees at https://protobuf.dev/support/cross-version-runtime-guarantee.(例: `gencode 5.29.0 runtime 5.27.5` なら、「設計図(Gencode)はバージョン5.29.0で作られたのに、実際に動かす部品(Runtime)が古いバージョンの5.27.5だからダメだよ」という意味です)

そもそも Protobuf って何?

Protobuf (Protocol Buffers) は、コンピューター同士がデータをやり取りするためのルール(形式)を決める技術の一つです。プログラムの中で使われるデータを、効率よく保存したり送受信したりするために使われます。

- `.proto` ファイル: データの「設計図」のようなものです。どんなデータをどんな名前で扱うかを定義します。

- コンパイラ: この設計図 (`.proto` ファイル) を元に、各プログラミング言語(Pythonなど)で実際にデータ扱えるようにする「部品」となるコード(例: `runtime_pb2.py`)を自動生成します。

- ライブラリ (Runtime): 生成されたコードが実際に動くために必要な、基本的な機能を提供します。

なぜエラーが起きるの?

今回のエラーは、`rl-swarm` の中で使われている `hivemind` というプログラム(や、それに関連する別のプログラム)が、「バージョンX.Y.ZのProtobuf設計図」を元に作られた部品コード (`gencode`) を持っているのに、あなたのパソコンのPython環境に入っているProtobufライブラリ (`runtime`) が「バージョンA.B.C」で、バージョンが食い違っているために発生します。

特に、「部品コード (`gencode`) を作ったバージョン」よりも「ライブラリ (`runtime`) のバージョン」が古い場合にこのエラーが出ます(新しい機能に対応できないため)。

設定ファイル (`requirements-hivemind.txt`) が、別の設定ファイル (`requirements.txt`) と違うバージョンのProtobufを指定していることが、この食い違いの原因となることがあります。

どうすれば直せるの? (試した方法)

この問題を解決するために、いくつか方法を試しました。エラーが出た時に試してみてください。

対応策 1:Protobuf を正しいバージョンで入れ直す

一番シンプルな方法です。エラーメッセージで「gencode X.Y.Z」と表示されていたバージョンのProtobufをインストールし直します。

# 今入っているProtobufを削除

pip uninstall protobuf

# エラーメッセージに出ていた Gencode バージョンを指定してインストール

pip install protobuf==X.Y.Z対応策 2:関連プログラムをまとめて入れ直す

`hivemind` と Protobuf の両方を一旦削除し、正しいバージョンの Protobuf を先にインストールしてから、`hivemind` を入れ直します。

# hivemind と Protobuf を削除 (-y オプションは確認なしで削除)

pip uninstall -y hivemind protobuf

# 正しい Gencode バージョンの Protobuf をインストール

pip install protobuf==X.Y.Z

# hivemind の設定ファイルを使って hivemind を再インストール

pip install -r requirements-hivemind.txt対応策 3:Protobuf の部品コードを作り直す

少し高度な方法です。今インストールされているProtobufライブラリに合わせて、`hivemind` の中にある Protobuf の部品コード (`runtime_pb2.py` など) を、あなたの環境で作り直します。

# コード生成ツール (grpc-tools) をインストール (もしまだなら)

pip install grpcio-tools

# hivemind の部品コードがあるフォルダに移動

# (パスは環境によって少し違うかもしれません。エラーが出たら確認してください)

cd .venv/lib/python3.12/site-packages/hivemind/proto

# 古い部品コードを削除 (他にも _pb2.py や _pb2_grpc.py があれば削除)

rm -f runtime_pb2.py runtime_pb2_grpc.py

# 設計図 (.proto) から、今のProtobufバージョンに合わせて部品コードを再生成

python -m grpc_tools.protoc -I. --python_out=. --grpc_python_out=. runtime.proto

# (もし runtime.proto 以外にも .proto ファイルがあれば、それらも指定する必要があるかも)

# 元のプロジェクトフォルダに戻る

cd ../../../../../..対応策 4:`hivemind` を特別にインストールする

Protobuf のバージョンを固定した後、`hivemind` をインストールする際に、他の依存プログラムを自動で入れないように指示し ( `--no-deps` )、後から必要なものだけを手動でインストールする方法です。

# まず hivemind と protobuf を削除

pip uninstall -y hivemind protobuf

# エラーで要求されていた Gencode バージョンの Protobuf をインストール

pip install protobuf==5.29.0 # (例: バージョン 5.29.0 が要求されていた場合)

# hivemind を、依存関係を無視してインストール

# (特定のコミットを指定していますが、最新版で試す場合は末尾の @... を削除)

pip install --no-deps git+https://github.com/learning-at-home/hivemind.git@10f82ee9e080c4fdbc95f2f26971a7afd55f43fa

# hivemind が動くのに最低限必要な他のプログラムを手動でインストール

pip install multiaddr@git+https://github.com/multiformats/py-multiaddr.git@e01dbd38f2c0464c0f78b556691d655265018cce

pip install scipy msgpack sortedcontainers uvloop grpcio-tools configargparse py-multihash cryptography pydantic- メモリエラー (Mac / Apple Silicon)で停止してしまう

Apple Silicon搭載のMac (M1, M2, M3など) で `rl-swarm` を実行していると、以下のようなメモリエラーでトレーニングが停止することがあります。

RuntimeError: MPS backend out of memory (MPS allocated: X.XX GB, other allocations: Y.YY GB, max allowed: ZZ.ZZ GB). Tried to allocate AA.AA MB on private pool. Use PYTORCH_MPS_HIGH_WATERMARK_RATIO=0.0 to disable upper limit for memory allocations (may cause system failure).なぜエラーが起きるの?

- MPSとは?: Apple Silicon Macに搭載されているGPU (グラフィック処理装置) を、Pythonの機械学習ライブラリ (PyTorch) から使うための仕組みです。これにより計算が速くなります。

- メモリ不足: このエラーは、MPSが計算のために使おうとしたメモリ (RAMの一部をGPUと共有して使うメモリ) が、システムで許可されている上限を超えてしまったために発生します。モデルの計算には大量のメモリが必要になることがあります。

- エラーメッセージの意味: 「MPSが X.XX GB、他のプログラムが Y.YY GB 使っていて、最大 ZZ.ZZ GB まで使えるところに、さらに AA.AA MB を確保しようとして失敗したよ」という意味です。

主な対応策:環境変数を設定する

ターミナルで以下のコマンドを実行してから、`./run_rl_swarm.sh` を再度実行します。これは、「PyTorchがメモリをどれくらい使うかの上限設定を緩める」というおまじないです。

export PYTORCH_MPS_HIGH_WATERMARK_RATIO=0.0

./run_rl_swarm.sh- 注意点: この設定を使うと、プログラムはより多くのメモリを使おうとします。これによりメモリエラーは解消される可能性が高いですが、まれにMac全体の動作が不安定になる(他のアプリが遅くなる、システムが応答しなくなるなど)リスクも少しあります。

もし上記の方法で解決しない、またはシステムが不安定になる場合:

- バッチサイズを小さくする: 設定ファイル(`hivemind_exp/configs/mac/...`) 内の `per_device_train_batch_size` の値を小さくする(例: 4 -> 2)。一度に処理するデータ量を減らすことで、メモリ使用量を抑えます。

- モデルサイズを小さくする: より軽量なモデルを使うことを検討します (設定ファイル内の `model_name_or_path` を変更)。ただし、これは学習性能に影響します。

- 他のプログラムを終了する: `rl-swarm` 実行中に、他のメモリを大量に消費するアプリケーション(動画編集ソフト、多くのブラウザタブなど)を閉じておくことも有効です。

現状の説明は以上です。今後のフェーズについても情報を追記していく予定ですが、最新情報については公式を追っておくことを推奨します。

まとめ

gensynは「分散型AI計算ネットワーク」という先進的な領域で、暗号学的な検証技術を使い、巨大クラウドに匹敵するリソースを誰もが利用できるようにしようとしています。

AI×ブロックチェーン領域における大きな潮流の一端として、今後の展開が楽しみです。